LLMO

Optimierung für Large Language Models

LLMO (Large Language Model Optimization) bezeichnet die gezielte Aufbereitung von Inhalten für generative KI-Systeme wie ChatGPT, Google AI Overviews oder Perplexity. Das Ziel dieser noch jungen Disziplin ist es, Marken und Inhalte in den Antworten solcher Sprachmodelle sichtbar zu machen. Damit ist die Bedeutung von LLMO vergleichbar mit der Rolle von SEO im klassischen Suchmaschinenmarketing.

Das Wichtigste zu LLMO & GAIO für Dich zusammengefasst:

- LLMO steht für Large Language Model Optimization und bezeichnet die Optimierung von Inhalten für generative Sprachmodelle wie ChatGPT, Gemini oder Claude.

- Ziel ist es, dass Inhalte in den Antworten generativer KI genannt, zitiert oder verlinkt werden.

- Die KI-Trainingsdaten lassen sich kaum direkt beeinflussen, relevant ist daher die Optimierung für Modelle mit der Zugriff auf Echtzeitdaten aus dem Netz (Retrieval Augmented Generation).

- Klassische Suchmaschinen werden laut Prognosen zunehmend durch KI-Assistenten ersetzt – wer nicht in KI-Antworten auftaucht, verliert digitale Sichtbarkeit.

- Der Einfluss klassischer SEO hängt davon ab, welche Quellen (etwa Bing und Google) das Sprachmodell nutzt.

- In der LLMO wichtige Faktoren sind etwa eine natürliche Sprache, strukturierte Inhalte mit kurzen und präzisen Antworten sowie Erwähnungen der eigenen Marke im Internet.

- URLs spielen für LLM kaum eine Rolle. Wichtiger sind die Qualität und das Format des Inhalts.

Was ist LLMO?

LLMO steht für Large Language Model Optimization, also die gezielte Optimierung für große Sprachmodelle wie ChatGPT, Claude oder Google Gemini. Ziel dieser Praxis ist es, die Antworten und Ausgaben solcher generativer KI‑Systeme gezielt zu beeinflussen. Dabei geht es nicht nur um klassische Chatbots, sondern auch um sogenannte Generative Engines wie Perplexity AI oder die Search Generative Experience (SGE) von Google und ihre AI Overviews.

Im Unterschied zur klassischen Suchmaschinenoptimierung (SEO), bei der Keywords, Backlinks oder technisches Crawling im Vordergrund stehen, geht es bei LLMO darum, Inhalte maschinell verständlich, kontextreich und strukturiert zu gestalten. Du optimierst also nicht mehr nur für Suchalgorithmen, sondern für Sprachmodelle, die Texte analysieren, interpretieren und in neue Zusammenhänge setzen.

Grundlegende Maßnahmen in der LLMO sind unter anderem:

- Inhalte mit klarer Struktur und natürlicher Sprache statt Keyword-Fokussierung

- Aufbau von Vertrauens- und Autoritätssignalen, die für LLMs relevant sind

- Optimierung für Antworten auf Kontextbasis anstelle von Keyword-Rankings

LLMO konzentriert sich darauf, wie Inhalte beschaffen sein müssen, damit sie von Sprachmodellen aktiv genutzt werden. Dabei spielt die reine Manipulation der KI-Trainingsdaten kaum eine Rolle – diese sind nur schwer und mit erheblichem Aufwand zu beeinflussen.Stattdessen liegt der wirksamere Hebel in der Phase der Antwortgenerierung, insbesondere durch Mechanismen wie Retrieval Augmented Generation (RAG). Die Modelle greifen mitunter in Echtzeit auf externe Datenquellen zu. Und genau an dieser Stelle kannst Du mit gezieltem Content und einer klaren Struktur Einfluss auf Deine Sichtbarkeit in KI-Antworten nehmen.

Die Ziele von Large Language Model Optimization

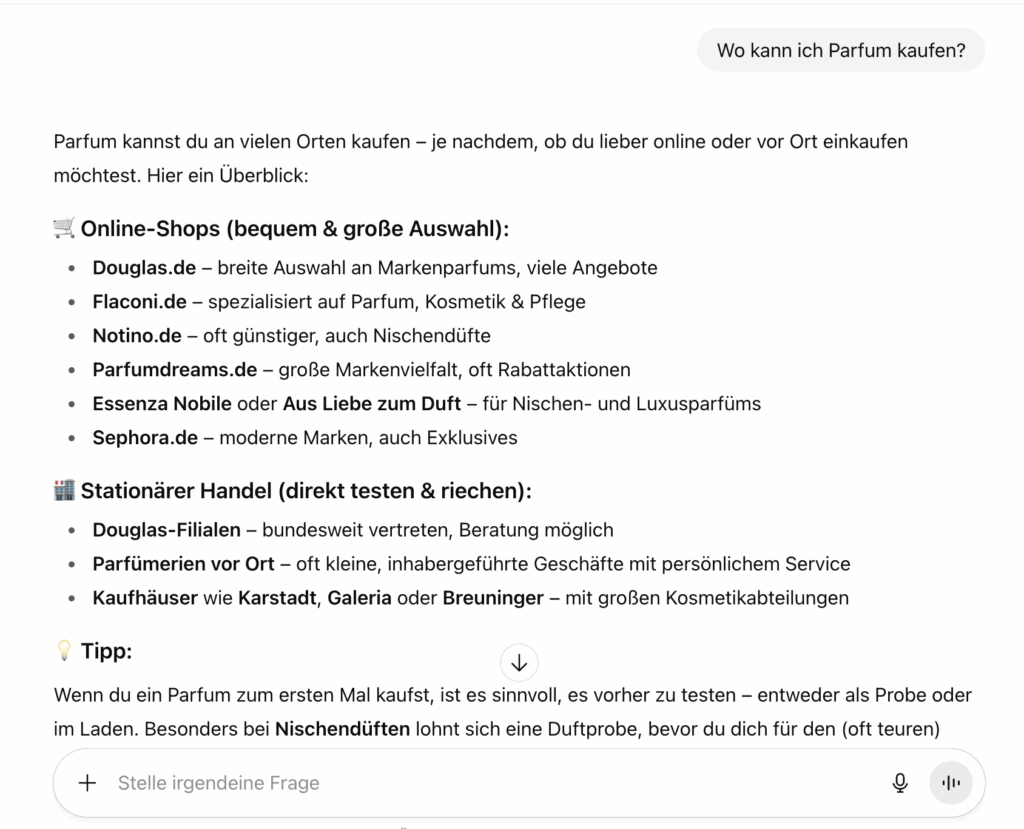

Der zentrale Zweck von Large Language Model Optimization besteht darin, die Sichtbarkeit Deiner Inhalte, Marke oder Angebote in den Antworten generativer KI-Systeme zu erhöhen. Systeme wie ChatGPT, Perplexity, Claude, Gemini oder Microsoft Copilot greifen mitunter auf eine Vielzahl von Quellen zurück, um Nutzern präzise Antworten zu liefern. LLMO kann bewirken, dass Dein Content dabei öfter genannt, zitiert oder verlinkt wird.

Dabei verfolgst Du im Wesentlichen zwei primäre Ziele:

- Inhalte in referenzierten Quellen: Wenn Sprachmodelle auf externe Informationen zurückgreifen, zählen strukturierte, themenrelevante und gut gepflegte Inhalte. Mitunter geben Sie die Quellen für ihre Antworten an und verlinken diese. Dein Ziel ist es, dass Deine Website als vertrauenswürdige Informationsquelle mit einem Link erwähnt wird.

- Direkte Nennung Deiner Marke, Produkte oder Leistungen in KI-Antworten: Auch ohne direkten Link kann es ein entscheidender Vorteil sein, wenn Deine Marke oder Dein Angebot in generierten Texten als Lösung oder Empfehlung auftaucht.

Damit dies gelingt, verfolgt LLMO verschiedene Teilziele:

- Höhere Sichtbarkeit in generativen Ergebnissen: Ob durch Verlinkung oder Markennennung, Du wirst Teil der Antwortlogik von KI-Systemen. Das kann Aufmerksamkeit und Traffic bringen sowie Deine digitale Präsenz stärken.

- Aufbau von Autorität: Wenn KI-Systeme Deine Inhalte regelmäßig als Referenz verwenden, positionierst Du Dich langfristig als thematische Autorität. Das stärkt nicht nur Dein Markenimage, sondern auch Deine Position im digitalen Wettbewerb.

- Optimierte Nutzererfahrung: Klare, gut strukturierte Inhalte helfen nicht nur der KI bei der Verarbeitung, sondern auch Nutzern, die die Ergebnisse lesen. Je besser Deine Inhalte aufbereitet sind, desto eher liefern sie schnelle und hilfreiche Antworten. Das kann sich auch positiv auf die Relevanz in klassischen Suchmaschinen auswirken.

LLMO, GAIO und Co.: Worin bestehen die Unterschiede?

Derzeit gibt es noch keine einheitliche Terminologie für diese neue Disziplin. Neben LLMO werden auch Begriffe wie GAIO (Generative Artificial Intelligence Optimization), GEO (Generative Engine Optimization), AIO (Artificial Intelligence Optimization) oder AEO (Answer Engine Optimization) verwendet. Sie alle beschreiben Ansätze, Inhalte für generative KI-Systeme sichtbarer zu machen, unterscheiden sich aber mitunter in ihrer exakten Zielsetzung. Teilweise können sie jedoch auch als Unterbegriffe von LLMO verstanden werden.

- AI Optimization (AIO): AIO ist die allgemeinste aller Bezeichnungen. Sie bezeichnet jede Form der Optimierung im Zusammenhang mit künstlicher Intelligenz – unabhängig davon, ob es sich um Sprachmodelle, Empfehlungssysteme oder andere KI-Technologien handelt. Der Begriff ist sehr weit gefasst und lässt viel Interpretationsspielraum.

- Answer Engine Optimization (AEO): AEO betont die Rolle von KI-Systemen als Antwortgeber – also als „Answer Engines“. Ziel ist es, mit den eigenen Inhalten möglichst prominent in den Antworten dieser Systeme vertreten zu sein.

- Generative AI Optimization (GAIO): Im Fokus steht die Optimierung für generative KI im weiteren Sinne – also nicht nur für Sprachmodelle, sondern auch für andere generative Anwendungen wie Bild- oder Audio-KI. Die Bezeichnung GAIO ist jedoch weit gefasst und kann je nach Kontext unterschiedlich interpretiert werden. Häufig wird der Begriff synonym mit LLMO verwendet.

- AI SEO: Diese auch als KI SEO bezeichnete Variante lehnt sich bewusst an klassische SEO-Begriffe an und legt den Fokus auf die Frage, wie Inhalte für KI-Suchsysteme – etwa Chatbots mit Webzugriff oder generative Suchsysteme – optimiert werden können.

Warum ist Large Language Model Optimization wichtig?

Die Relevanz von LLMO wächst und könnte das Nutzerverhalten im Web grundlegend verändern. Immer mehr Menschen greifen nicht mehr auf klassische Suchmaschinen zurück, sondern stellen ihre Fragen direkt an KI-gestützte Assistenten wie ChatGPT oder Perplexity. Gartner schreibt, dass sich die Nutzung klassischer Suchmaschinen bis 2026 um rund 25 Prozent zugunsten von KI-Chatbots verringern wird.

Wer in den KI-Antworten nicht auftaucht, verliert folglich an Sichtbarkeit. Die Sprachmodelle liefern Antworten jedoch direkt, ein Klick auf eine Website ist dazu nicht mehr notwendig.

Dies bringt einige Veränderungen mit sich:

- Zero-Click-Suchen treten häufiger auf: Marken, die in KI-Antworten auftauchen, bleiben sichtbar, generieren aber nicht zwangsläufig Klicks. So zeigt eine Studie von pewresearch.org, dass auf Suchergebnisseiten von Google, die KI-Antworten aus AI Overviews enthalten, im Schnitt nur noch acht Prozent der Nutzer auf eine Webseite klicken.

- Markennennungen werden wichtiger als Rankings: Du solltest nicht nur auf Positionen in der Google-SERP setzen, sondern darauf, dass Deine Marke in KI-Antworten als Quelle oder Empfehlung genannt wird.

- Die Art des Traffics ändert sich: Steigt die Zahl der Direktzugriffe auf Deine Webseite, erscheint Deine Marke oder Seite möglicherweise in den Antworten von generativen Sprachassistenten. Die Nutzer klicken nicht auf den Link in der KI-Antwort, rufen die Webseite stattdessen aber zu einem späteren Zeitpunkt selbst auf. Der organische Traffic hingegen kann währenddessen weiter schrumpfen.

Welche Bedeutung hat SEO für LLMO?

Wie stark sich klassische SEO-Maßnahmen auf LLMO auswirken, hängt im Wesentlichen davon ab, wie ein Sprachmodell seine Antworten generiert und auf welche Datenquellen es zurückgreift. Large Language Models wie ChatGPT, Copilot, Perplexity oder Gemini nutzen in ihren aktuellen Versionen Retrieval-Systeme, die ihre Informationen zumindest teilweise aus den Suchmaschinenindizes beziehen.

Je größer der Einfluss von Suchmaschinenrankings dabei auf die Quellenauswahl ist, desto stärker kannst Du mit bewährten SEO-Strategien auf LLMO einwirken. Inhalte, die in Suchmaschinen wie Google gut ranken, haben möglicherweise eine höhere Chance, von Sprachmodellen zitiert oder referenziert zu werden. Beachte aber, dass nicht jedes Large Language Model die gleichen Suchmaschinen nutzt.

Etwa im klassischen Google SEO sind neben technischen Faktoren unter anderem Qualitäts- und Relevanzsignale und technische Faktoren wichtig. Da LLMs Webseiteninhalte zerlegen, statt sie als zusammenhängendes Dokument zu speichern, ist die Relevanz des gesamten Inhalts für LLMO weniger bedeutend als seine Qualität und die Autorität der Marke. Das bedeutet: Large Language Models interpretieren Inhalte anders als klassische Suchmaschinen. Sie zerteilen Deinen Content in semantische Einheiten und rechnen diese in mathematische Vektoren um. Entsprechen diese mit einiger Nähe denen der Suchanfrage, wird auf Basis von Wahrscheinlichkeiten eine Antwort aus passenden Informationseinheiten verschiedener Quellen generiert. Klassische Relevanzsignale wie die Verwendung von Keywords spielen hierbei höchstens eine untergeordnete Rolle.

Stattdessen konzentriert sich die LLMO auf Qualitätskriterien wie E-E-A-T (Experience, Expertise, Authoritativeness, Trustworthiness) und die Verwendung einer natürlichen Sprache sowie von semantisch relevanten Entitäten. Derartige Signale helfen Sprachmodellen, die Faktentreue sowie inhaltliche Tiefe Deiner Inhalte zu erkennen, und können darüber entscheiden, ob ein Inhalt als Quelle in einer KI-Antwort auftaucht.

Worin unterscheiden sich SEO und LLMO?

Während SEO vereinfacht formuliert dafür sorgt, dass Inhalte von Suchmaschinen gefunden, indexiert und gerankt werden, geht es bei LLMO darum, dass Deine Inhalte verstanden, eingeordnet und von KI-Systemen zitiert werden.

| Klassische SEO | LLMO |

| Ziel: Traffic durch gute organische Rankings | Ziel: Erwähnung oder Erscheinen als Quelle in KI-generierten Antworten |

| Optimierung für Keyword | Fokus auf Kontext und Faktentreue |

| Meta-Tags und strukturierte Daten | Klar strukturierte Inhalte in natürlicher Sprache |

| Backlinks als wichtiger Rankingfaktor | Semantische Optimierung für Sprachmodelle |

| Optimierung der eigenen Webseite im Fokus | Netzweite Nennungen der eigenen Marken in semantischer Nähe von relevanten Entitäten |

Klassisches SEO bleibt für LLMO relevant

Mit dem Start von ChatGPT-5 im August 2025 zeigte sich erneut, dass klassische Suchmaschinenoptimierung auch künftig eine zentrale Rolle bei der Optimierung für generative Sprachmodelle spielt. Die neue GPT-Generation wurde nicht in erster Linie auf möglichst umfassendes Weltwissen trainiert, sondern auf die Fähigkeit, gezielt Informationen zu recherchieren, sinnvoll zu verarbeiten und strukturiert darzustellen.

Um an aktuelle und relevante Informationen zu gelangen, nutzt ChatGPT-5 unter anderem RAG-basierte Zugriffe auf Suchmaschinen. Inhalte, die dort gut auffindbar sind, haben eine deutlich höhere Chance, in die Antwortgenerierung des Modells einzufließen. Damit wird deutlich: Zwischen SEO und der Optimierung für Large Language Models (LLMO) besteht ein enger Zusammenhang – und mit Blick auf die Zukunft dürften die Grenzen zwischen beiden Disziplinen zunehmend verschwimmen.

Wie funktioniert ein Large Language Model?

Large Language Models (LLMs) wie GPT oder Gemini basieren auf dem Ansatz der natürlichen Sprachverarbeitung oder Natural Language Processing (NLP). Dieses unterteile sich in zwei Teilbereiche:

- Natural Language Understanding (NLU): Das Verstehen und Interpretieren menschlicher Sprache.

- Natural Language Generation (NLG): Das Generieren neuer, sinnvoller Antworten.

Beim Training eines LLMs steht das Natural Language Understanding, also die Fähigkeit, große Mengen an Textdaten statistisch zu verarbeiten und Zusammenhänge zu erkennen, im Vordergrund. Bei der späteren Antwortgenerierung nutzt das Modell NLG, um auf Basis dieser erlernten Muster passende Inhalte zu formulieren.

Diese Methode ermöglicht es generativen Sprachmodellen, die menschliche Sprache statistisch zu analysieren, zu verstehen und darauf zu reagieren. Dieser Prozess erfolgt jedoch nicht auf semantischer Ebene, sondern auf Basis mathematischer Muster.

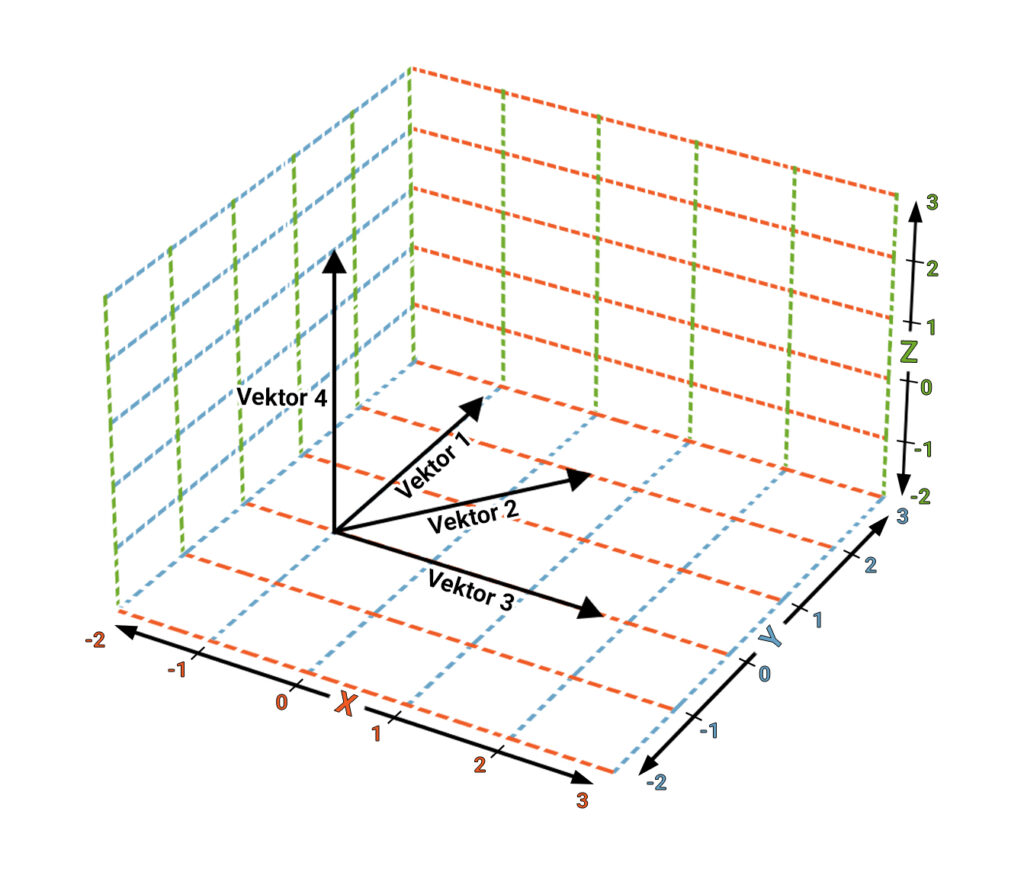

Tokens, Vektoren und semantische Räume

Bevor ein LLM Sprache verarbeiten kann, wird der Text in viele kleine Bedeutungsfragmente, sogenannte Tokens, zerlegt. Diese werden anschließend in Vektoren überführt. Dabei handelt es sich um mathematische Repräsentationen des Tokens in einem simulierten mehrdimensionalen Raum, der oft als semantischer Raum bezeichnet wird. Die Vektoren können dabei etwa Entitäten, Wörter oder diesen zugeordnete Eigenschaften und Attribute repräsentieren.

Über die Vektoren werden die Bedeutungsfragmente so im semantischen Raum angeordnet, dass semantisch ähnliche Einheiten näher beieinanderliegen. Wenn etwa der Begriff Digitaleffects in den Trainingsdaten häufig mit Wörtern wie SEO Agentur oder Suchmaschinenoptimierung vorkommt, werden deren Vektoren automatisch näher beieinander positioniert.Das bedeutet: Je häufiger Begriffe Kookkurrenzen darstellen, also gemeinsam im Internet in einem bestimmten Kontext genannt werden, desto näher rücken sie im Vektorraum zusammen. Je stärker die semantische Beziehung gewichtet wird, desto relevanter wird wiederum die Quelle des Tokens – oder die im semantischen Raum verortete Marke – für passende Suchanfragen.

Die Bedeutung von Entitäten

Ein wichtiger Bestandteil der natürlichen Sprachverarbeitung ist die Erkennung von klar identifizierbaren Einheiten wie Personen, Marken, Produkten oder Orten. Diese Entitäten werden im semantischen Raum als Knotenpunkte betrachtet und mit weiteren Attributen in Verbindung gebracht. Je häufiger eine Entität im Kontext bestimmter Eigenschaften auftritt, desto wahrscheinlicher wird sie mit diesen verbunden.

LLMs bauen also kein echtes semantisches Weltverständnis auf, sondern bewerten Inhalte und generieren Antworten auf der Basis von Wahrscheinlichkeiten, statistischen Werten und Kontextanalysen. Das Modell weiß nicht, ob eine Information korrekt oder falsch ist. Stattdessen erlernt es, welche Begriffe typischerweise zusammengehören, um thematisch passende Antworten zu generieren.

Welche Arten von Large Language Models gibt es?

Nicht jedes Large Language Model funktioniert gleich. Das hat direkte Auswirkungen darauf, wie gut Du es durch LLMO beeinflussen kannst. Abhängig von der Art ihrer Informationsbeschaffung und Datenbasis lassen sich LLMs in zwei Hauptkategorien einteilen:

Vortrainierte, statische LLMs

Diese Modelle nutzen ausschließlich antrainierte Daten zur Generierung von Antworten. Sie greifen nicht auf aktuelle Informationen oder externe Quellen zu, sondern arbeiten mit einem feststehenden Wissensstand, der zum Zeitpunkt des Trainings angeeignet wurde. Solche Modelle funktionieren ähnlich wie ein Lexikon, das über eine bestimmte Menge an Einträgen verfügt, aber keine neuen Informationen aufnimmt. Ein Beispiel hierfür war die erste Version von ChatGPT-4 im Standardmodus.

Die Möglichkeiten zur Optimierung sind dadurch stark eingeschränkt. Inhalte, die nicht im ursprünglichen Trainingsdatensatz enthalten sind, können nicht nachträglich integriert oder beeinflusst werden.

Search-augmented bzw. RAG-gestützte LLMs

Diese Modelle kombinieren ihr trainiertes Basiswissen mit aktuellen Echtzeitinformationen, die sie bei Bedarf aus dem Web abrufen. Dazu nutzen Sie eine Technik, die als Retrieval Augmented Generation (RAG) bezeichnet wird. In diese Kategorie gehören beispielsweise Systeme wie ChatGPT, Gemini oder Claude mit Webzugriff. Zusätzlich werden einige Modelle in die klassische Suche eingebunden. Dazu zählen etwa Perplexity, die Bing KI oder Googles AI Overviews.

Derartige Modelle sind relevant für die LLMO, denn Du kannst Inhalte gezielt so aufbereiten, dass sie von diesen LLMs idealerweise abgerufen und zitiert werden. Hierbei spielen unter anderem die Sichtbarkeit in relevanten Quellen, die thematische Struktur und die Qualität der Inhalte eine entscheidende Rolle.

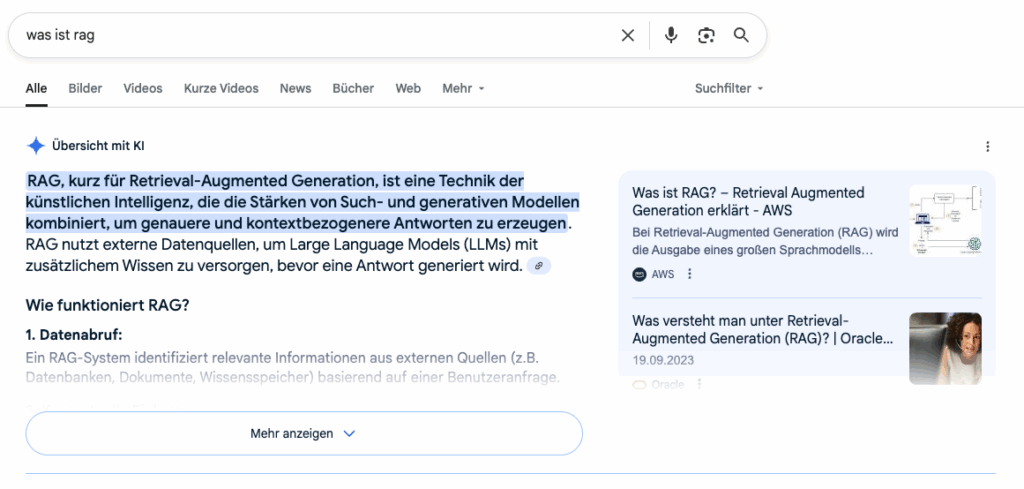

Retrieval Augmented Generation (RAG)

Retrieval Augmented Generation (RAG) ist ein technischer Ansatz, die Antworten generativer Sprachmodelle präziser zu gestalten. Während statische LLMs auf Basis vortrainierter Daten häufig mit veralteten, unvollständigen oder falschen Informationen antworten, greifen Modelle mit RAG zusätzlich auf externe Wissensquellen zurück, um möglichst korrekte und aktuelle Antworten zu geben. RAG reduziert also „Halluzinationen“ – falsche und frei erdachte Aussagen des Models.

Das RAG-Verfahren läuft typischerweise in drei Schritten ab:

- Indizierung: Externe Inhalte werden in kleine Textbestandteile zerlegt, in Vektoren überführt und in einer semantischen Datenbank gespeichert.

- Retrieval: Bei einer Nutzeranfrage durchsucht das System diese Datenbank nach den semantisch passenden Textabschnitten.

- Antwortgenerierung: Die gefundenen Informationen werden vom LLM im Kontext der Anfrage zusammengetragen und zu einer Antwort ausformuliert.

Warum ist RAG so relevant für LLMO?

Wenn Du möchtest, dass Deine Inhalte in Antworten von KI-Systemen wie ChatGPT, Gemini oder Perplexity auftauchen, dann ist RAG ein zentraler Mechanismus, über den das gelingen kann, denn er beeinflusst maßgeblich:

- Welche Quellen oder Marken sichtbar werden: Inhalte, die auffindbar, relevant und vertrauenswürdig sind, haben eine deutlich höhere Chance, vom Retrieval-System ausgewählt zu werden.

- Wie Inhalte priorisiert werden: KI-Systeme bevorzugen häufig seriöse und gut strukturierte Quellen, etwa Fachportale, Nachrichtenseiten, Branchenpublikationen oder fundierte Diskussionen in Foren.

Optimierung für generative Sprachmodelle mit RAG

Wenn Du Inhalte gezielt für RAG optimierst, erhöhst Du die Wahrscheinlichkeit, dass Sprachmodelle Deine Website, Marke oder Produkte in ihren Antworten berücksichtigen. Damit Deine Inhalte von RAG-basierten Systemen erfasst und verwendet werden, sollten sie:

- klar strukturiert und leicht extrahierbar sein,

- inhaltlich hochwertig und sachlich korrekt sein,

- semantisch gut eingebettet und gemeinsam mit relevanten Begriffen (Entitäten) auftreten,

- idealerweise bereits gut bei Suchmaschinen ranken – da viele RAG-Systeme auf bestehende Suchindizes wie Bing oder Google zurückgreifen,

- über konsistente Informationen verfügen, die gut strukturiert auf und außerhalb der eigenen Website bereitstehen – etwa im Footer, in Listen, Tabellen und in klaren Absätzen.

Wie Dir möglicherweise auffällt, ist die Anpassung Deiner Inhalte für LLM vergleichbar mit der Optimierung für Featured Snippets, aber mit mehr Einflussfaktoren und weniger Vorhersagbarkeit.

Gratis SEO-Strategie Session sichern

1. Session

anfragen

2. Roadmap

erhalten

3.Marktanteile

erobern

Frage jetzt Deine persönliche Strategie-Session in einem 1-on-1-Videocall mit Christian B. Schmidt an. Statt allgemeiner „SEO-Tipps“ bekommst Du Deine individuelle Challenger Roadmap, um neue Marktanteile zu erobern.

Limitiert auf 10 Sessions pro Monat und nur für Hidden Champions mit Wachstumszielen.

Grundlegende LLMO-Leitlinien

Mit dem grundlegenden Wissen über die Funktionsweise von Large Language Models lassen sich einige hilfreiche Prinzipien für die Optimierung ableiten:

1. Externe Quellen sind der Hebel

Auch wenn Sprachmodelle wie GPT oder Claude theoretisch durch öffentlich zugängliche Daten trainiert werden, kannst Du diese Trainingsprozesse nicht direkt beeinflussen. Die Trainingszyklen sind selten, kostenintensiv und kaum steuerbar. Für Unternehmen ist es daher effektiver, sich auf Inhalte zu konzentrieren, die über Retrieval Augmented Generation während der Antwortgenerierung eingebunden werden.

Sprachmodelle mit RAG greifen bei aktuellen Informationen auf externe Quellen zurück – dort liegt Dein Einflussbereich.

- Für SearchGPT beziehungsweise ChatGPT Search galt bisher Bing als zentrale Datenquelle. Mittlerweile gibt es jedoch erste Erkenntnisse, die nahelegen, dass SearchGPT auf Daten aus Google zurückgreift.

- Für Google Gemini und AI Overviews spielt die Google-Suche eindeutig die entscheidende Rolle.

Wenn Deine Inhalte dort sichtbar sind, steigen die Chancen, auch in KI-generierten Antworten aufzutauchen. Die klassische Suchmaschinenoptimierung ist daher auch für LLMO relevant.

2. Antworten stehen im Vordergrund

Während die Suchmaschinenoptimierung Seiteninhalte nach Suchintentionen und Keywords strukturiert, fokussiert sich LLMO auf Antwortqualität. Für Sprachmodelle zählt nicht die einzelne URL, sondern ob Deine Inhalte eine konkrete, hilfreiche Antwort auf eine komplexe Nutzerfrage liefern. Umfangreiche Themen- und FAQ-Seiten gewinnen dadurch vermutlich wieder an Bedeutung.

3. Komplexere Nutzereingaben erfordern neue Keyword-Strategien

In der Interaktion mit Chatbots stellen Nutzer detailliertere und nuanciertere Fragen als bei Google. Darum solltest Du nicht nur auf klassische Keywords setzen, sondern auch relevante Fragen, Longtail-Keywords und Antwortvarianten abdecken. Dafür eignen sich etwa:

- Fragen aus echten Chatbot-Dialogen

- SERP-Elemente wie „Weitere Fragen“ auf Google

- Erkenntnisse aus Kundenfeedback, Vertrieb oder Support

Diese Informationen helfen Dir, Inhalte so zu gestalten, dass sie den Kontext und die Absicht hinter einer Anfrage besser treffen und so wahrscheinlicher von einem Sprachmodell genutzt werden.

OnPage-Maßnahmen im LLMO

Im Mittelpunkt stehen die Relevanz und Struktur Deiner Inhalte. Langatmiger Fließtext ist möglicherweise kontraproduktiv. Stattdessen solltest Du um zentrale Keywords herum gezielt Fragen identifizieren und passende Antworten aufbauen – es zählt die klare, direkte Information.

Mitunter wird derzeit empfohlen, Inhalte gezielt auf einzelne Antworten hin zu optimieren. Doch ob das langfristig sinnvoll ist, ist nicht sicher. Die zitierten Quellen in generierten Antworten variieren mitunter mit jeder Wiederholung einer Frage oder je nach Fülle der Informationen zu einem Thema im Netz. Stattdessen lohnt es sich, Inhalte konsequent nach bewährten LLMO-Strategien aufzubereiten, um die Wahrscheinlichkeit, in generativen KI-Antworten aufzutauchen, generell zu erhöhen.

Die passende Content-Struktur für LLMO

- Orientiere Dich bei der Strukturierung des Contents am Aufbau der Antworten des jeweiligen Sprachmodells.

- Erstelle Ranch-Style-Content: Anstelle von holistischen Webseiten können separate Unterseiten zu den verschiedenen Detailaspekten eines Themas sinnvoll sein.

- Bereite Inhalte in für KI gut lesbaren Formaten auf: Bullet Points, Vergleiche, Tabellen

- Nutze strukturierte Daten (Schema.org).

Inhalte für LLM optimieren

- Liefere einzigartige Informationen mit echtem Mehrwert, die idealerweise nicht bereits in den Antworten oder auf anderen Websites auftauchen.

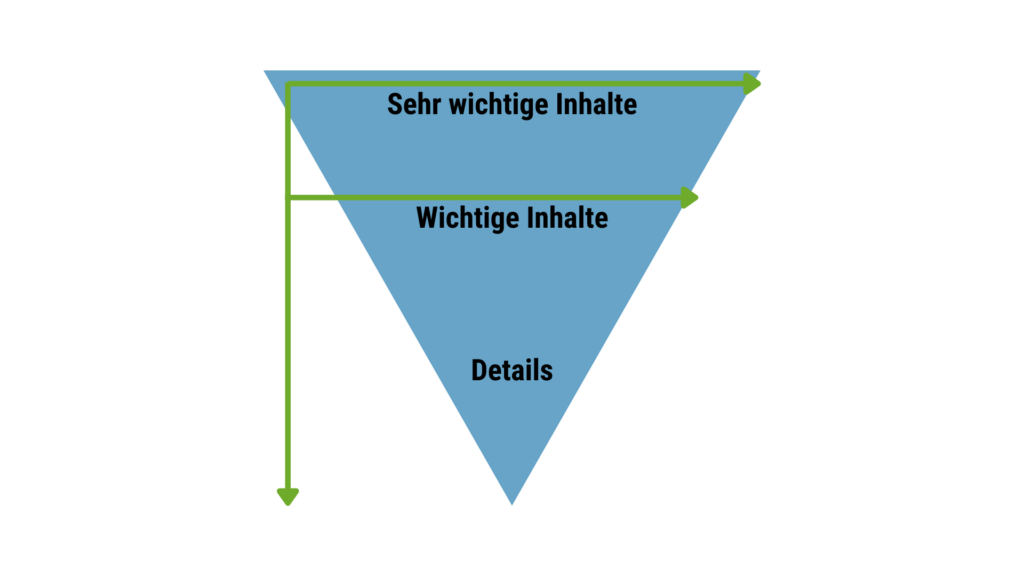

- Beginne längere Inhalte mit einer knappen Zusammenfassung der wichtigsten Aussagen.

- Starte jedes Kapitel mit einer kompakten Antwort auf die zentrale Frage und den wichtigsten Fakten.

- Integriere Statistiken, Daten sowie Zitate von bekannten Experten oder Institutionen, um Deine Informationsdichte und Glaubwürdigkeit zu stärken.

- Ergänze Quellenangaben als Beleg für Daten und Argumente.

Aufbereitung der Sprache

- Orientiere Dich daran, was bei Featured Snippets gut funktioniert

- Setze auf einfache, präzise und faktenorientierte Sprache.

- Fachbegriffe sollten kurz und präzise erklärt werden.

OffPage-Maßnahmen im LLMO

Die OffPage-Optimierung im Kontext von LLMO zielt darauf ab, Deine Marke außerhalb der eigenen Website in Sprachmodellen sichtbar zu machen. Anders als im klassischen SEO geht es hierbei nicht um Backlinks, sondern um prominente Erwähnungen im passenden thematischen Kontext auf vertrauenswürdigen Seiten. Diese können entweder direkt von Sprachmodellen bei der Antwortgenerierung verwendet oder langfristig in die Trainingsdaten übernommen werden.

Ziel ist es, mit Deinem Unternehmen auf Plattformen aufzutauchen, die von KI-Systemen regelmäßig durchsucht oder verarbeitet werden. Ein typisches Beispiel wäre die Aufnahme in eine Liste der besten Anbieter eines bestimmten Fachbereichs, etwa bei Sortlist oder Crunchbase. Solche Nennungen erhöhen die Wahrscheinlichkeit, dass Du bei KI-Abfragen als Referenz herangezogen wirst.

Besonders relevant für OffPage LLMO sind drei Plattformtypen:

- Große Foren und Plattformen mit User Generated Content wie reddit.com und YouTube.

- Webseiten und Profile von renommierten Publishern und Presse.

- Gut rankende Datenbanken mit strukturierten Unternehmensprofilen, etwa sortlist.de.

Um auf diesen Seiten für LLM sichtbar zu werden, führe folgende Maßnahmen durch:

- Sei in einschlägigen Foren und auf Plattformen wie YouTube aktiv. Steuere gegebenenfalls selbst Content bei oder sorge für Erwähnungen.

- Schalte hochwertigen gesponserten Content mit redaktionellen Inhalten bei renommierten Publishern und versuche, im Zuge von PR-Kampagnen auf großen Presseseiten erwähnt zu werden.

- Lege Unternehmensprofile in relevanten Datenbanken an und versuche, ein gutes Ranking in diesen zu erzielen.

Nicht jede Plattform lässt sich für LLMO nutzen. Entscheidend ist, dass die jeweilige Seite den Zugriff durch KI-Bots erlaubt. Ist der Bot blockiert (etwa über die robots.txt), kann der Inhalt weder gecrawlt noch in Antworten verarbeitet werden. Es empfiehlt sich daher, vorab zu prüfen, ob die Zielplattform den Zugriff entsprechender Bots zulässt.

Ausblick zu LLMO im digitalen Marketing

LLMO wird zunehmend zu einem zentralen Faktor für den Aufbau digitaler Sichtbarkeit. SEO bleibt relevant und kann je nach Sprachmodell – etwa bei Systemen, die auf Suchmaschinen-Retrieval wie Google oder Bing setzen – zukünftig als Bestandteil der Large Language Model Optimization betrachtet werden.

Da sich Sprachmodelle und generative Suchtechnologien stetig weiterentwickeln, wird sich auch LLMO dynamisch verändern. Marken, die bereits heute mit der Optimierung beginnen, schaffen die Grundlage für eine langfristige Sichtbarkeit in den Antworten künstlicher Intelligenzen.

Im Fokus stehen dabei Inhalte, die klar strukturiert, kontextbezogen, faktentreu und glaubwürdig sind. Unternehmen, die Expertise, Relevanz und Vertrauen vermitteln, erhöhen die Chance, in KI-generierten Antworten aufzutauchen. Die klassische Suchmaschinenoptimierung kann hierfür eine wichtige Grundlage liefern.

Christian optimiert seit 1998 Websites und berät Unternehmen seit 2005 im Online Marketing. Als Geschäftsführer der SEO-Agentur verantwortet er Marketing und Vertrieb. Gerne beantwortet er Fragen und sendet weitere Infos zu. Mehr über CBS