Technisches SEO

Technische Suchmaschinenoptimierung verständlich erklärt

Technisches SEO, häufig auch als Technical SEO bezeichnet, ist ein Teilbereich der Suchmaschinenoptimierung zur Verbesserung von Rankings in Suchmaschinen mithilfe technischer Optimierungen. Im Fokus steht dabei nicht nur der Quellcode der Webseite, sondern auch Serverkonfigurationen oder die barrierefreie Benutzbarkeit der Seite auf mobilen Endgeräten. Technisches SEO allein reicht für gewöhnlich nicht aus, um gute Rankings zu erzielen. Vielmehr ist es eine Voraussetzung für die Wirksamkeit weiterer Optimierungsmaßnahmen.

Die wichtigsten Aspekte von technischem SEO zusammengefasst:

- Der technische Zustand einer Webseite kann Deine Rankingchancen beeinflussen.

- Technisches SEO bildet daher die Grundlage für die Wirksamkeit weiterer Onpage-Maßnahmen.

- Damit eine Webseite in Suchmaschinen ranken kann, müssen ihre Inhalte für den Crawler zugänglich und indexierbar sein.

- Eine hierarchisch gegliederte, logische und einfache Seitenstruktur erleichtert es Nutzern und Suchmaschinen, sich auf der Webseite zurechtzufinden.

- Auch das Vermeiden doppelter Inhalte zählt zu den wichtigsten Aufgaben der technischen Suchmaschinenoptimierung.

Die wichtigsten Maßnahmen im technischen SEO

1. Optimiere die Kategorie- und URL-Struktur

Eine sprechende URL mit sinnvollen Bezeichnungen statt loser Zeichenkombinationen verschafft Nutzern einen ersten Eindruck davon, welchen Inhalt sie dahinter erwarten können. Eine hierarchisch und thematisch gegliederte URL- und Verzeichnisstruktur hilft zusätzlich auch Suchmaschinen wie Google, den Aufbau Deiner Webseite und ihrer Inhalte zu verstehen. Daher solltest Du bei der Gestaltung Deiner URLs ein paar Grundregeln einhalten:

- Gestalte die URLs sprechend, sodass sie den Seiteninhalt kurz beschreiben.

- Verzichte auf Umlaute und Ligaturen wie das “ß”, um Probleme bei der URL-Codierung zu vermeiden.

- Trenne Wörter mit einem Bindestrich (nicht mit einem Unterstrich) und halte die URLs möglichst kurz.

- Verwende das Hauptkeyword, verzichte aber auf Keyword-Stuffing.

- Wenn möglich, bilde die Kategoriestruktur der Webseite und Hierarchie der Inhalte auch auf URL-Ebene ab, damit Nutzer und Google den Kontext des Contents besser verstehen. Mehr dazu erfährst Du in unserem Beitrag zur Informationsarchitektur.

Ein Beispiel für eine kurze, prägnante und sprechende URL inklusive Keyword ist etwa unsere URL:

https://digitaleffects.de/seo-strategie/seo-kpi/

Sowohl Nutzer als Google erkennen sofort, um welches Thema es auf der Seite geht (SEO KPI) und in welchem Kontext das Thema behandelt wird (Kategorie: SEO-Strategie).

Eine logische Seitenstruktur entscheidet zudem darüber, wie gut sich die Seitenbesucher auf der Webseite zurechtfinden. Wähle daher eine Struktur, die eine intuitive Navigation mit kurzen Wegen ermöglicht. Idealerweise ist jede relevante Seite mit maximal 2 bis 3 Klicks von der Startseite aus erreichbar. Dies lässt sich nicht immer strikt umsetzen, sollte aber bei der Strukturierung der Seite bedacht werden. Denn auch Google findet leicht erreichbare Seiten schneller und indexiert den Seiteninhalt entsprechend früher.

2. Vermeide Duplicate Content

Taucht derselbe Inhalt auf mehreren Seiten auf, spricht man von Duplicate Content – doppelten Inhalten. Doppelte oder sehr ähnliche Inhalte können Deine Rankings gefährden, da die Suchmaschine nicht eindeutig bewerten kann, welcher der Inhalte für eine Suchanfrage relevant ist.

Das kann dazu führen, dass die Suchmaschine die ähnlichen oder doppelten Seiten gegeneinander testet – meist auf niedrigeren Positionen in den Suchergebnissen. Man spricht hierbei auch von einer Keyword-Kannibalisierung. Mitunter können doppelte Inhalte dabei sogar vollständig aus dem Index verschwinden. Technisches SEO muss Duplicate Content daher immer im Blick behalten.

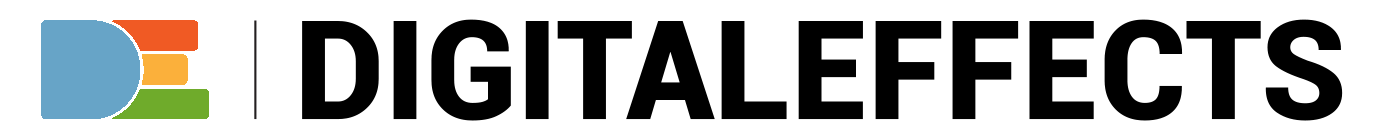

Duplicate Content kann verschiedene Ursachen haben. Neben Filter-URLs und verschiedenen URL-Varianten, die Du mithilfe des Canonical Tags als Duplikate auszeichnen kannst, kann auch eine fehlerhafte Kategoriestruktur für Probleme mit Duplicate Content sorgen. Etwa dann, wenn ein Produkt oder eine Unterkategorie über verschiedene Kategoriepfade erreichbar ist und dabei für jeden Pfad eine neue URL erstellt wird.

Beispiel: Ein Onlineshop für Schuhe führt sowohl die Unterkategorie “Nike + Sneaker” als auch “Sneaker + Nike”. Dadurch entstehen doppelte Kategorien.

Dieses Problem kannst Du lösen, indem Du nur eine Seite pro Produkt und Kategorie erstellst und von passenden Seiten der höheren Ebene sowie von der Navigation aus verlinkst. Doppelte Kategorien und Produktseiten solltest Du unbedingt vermeiden.

Übrigens: Auch Seiten mit unterschiedlichen Inhalten können miteinander um Rankings konkurrieren, wenn Du mehrere Seiten zu synonymen Keywords anlegst. Achte daher bei der Keyword-Recherche darauf, dass Du Synonyme gruppierst und nur zur Optimierung einer einzigen Seite verwendest.

3. Stelle die Indexierbarkeit relevanter Inhalte sicher

Ein verbreiteter Fehler, der oft im Kontext eines Launches oder Relaunches von Webseiten auftritt, ist eine falsch konfigurierte robots.txt-Datei. Hierin werden u. a. die Zugangsberechtigungen für Suchmaschinen-Robots – sogenannten Crawlern – geregelt. Mithilfe der robots.txt-Datei kannst Du den Google Crawler also davon abhalten, den Seiteninhalt zu analysieren. Das ist etwa dann eine gängige Praxis, wenn sich die Testumgebung einer Seite aufgrund eines anstehenden Relaunches im Wartungsmodus befindet oder Warenkorb-Seiten eines Onlineshops nicht gecrawlt werden sollen.

Relevante Inhalte, die in den Suchergebnissen von Google ranken sollen, sollten jedoch jederzeit für den Crawler abrufbar sein. Daher ist die Überwachung der robots.txt ein wichtiger Bestandteil von technischem SEO, insbesondere nach einem Relaunch. Denn oft wird die Anpassung der Datei nach dem Livegang der neuen Webseite schlicht vergessen.

Die robots.txt besteht immer aus zwei Elementen:

- User-Agent: der Bot oder Crawler, an den sich der Befehl richtet

- Befehl: Der Befehl “disallow: /” schließt alle betroffenen Dateien vom Crawling aus, der Befehl “allow: /” schließt alle betroffenen Dateien ein.

Beispiel 1:

User-agent: Googlebot

Disallow: /was-ist-crawling/

Der User-Agent “Googlebot” darf den Ordner deine-domain.de/was-ist-crawling/ und alle Unterverzeichnisse nicht crawlen.

Beispiel 2:

User-agent: *

Allow: /

Alle Crawler dürfen jeden auf die gesamte Webseite zugreifen. Da dies dem Standardverhalten der Crawler entspricht, ist diese Regel nicht zwingend notwendig.

Für gewöhnlich kannst Du die robots.txt einfach über den Browser aufrufen, indem Du die Domain und dahinter /robots.txt einträgst.

Beispiel: www.deine-domain.de/robots.txt

Zusätzlich solltest Du die Robots-Meta-Tags Deiner Inhalte überprüfen. Diese befinden sich direkt im Quellcode und können unterschiedliche Befehle enthalten. So unter anderem die Direktive “noindex”, die es der Suchmaschine untersagt, den Inhalt zu indexieren.

Für relevante Inhalte gilt daher die Direktive “index, follow”. Sie teilt dem Crawler mit, dass er den Seiteninhalt zur Indexierung übermitteln und den Links der Seite folgen darf. Da dies dem Standardverhalten des Crawlers entspricht, kann auf den Befehl jedoch auch verzichtet werden.

Tipp: Schließe Inhalte nie gleichzeitig per Robots-Meta-Tag und robots.txt von der Indexierung aus! Soll ein zuvor indexierter Inhalt nicht mehr in den Suchergebnissen erscheinen, etwa weil ein Produkt nicht mehr angeboten wird, nutze immer die Noindex-Direktive. Sie teilt Google mit, dass die Seite nicht mehr in den SERPs angezeigt werden soll.

Der Disallow-Befehl der robots.txt hingegen versperrt Google den Zutritt zur Seite. Die Suchmaschine kann also auch den Befehl “noindex” nicht mehr lesen und die Seite bleibt im Index, ohne dass Änderungen am Inhalt übernommen werden können.

4. Füge der Domain ein SSL-Zertifikat hinzu

Ein SSL-Zertifikat sorgt für eine verschlüsselte Übertragung von Informationen zwischen Deiner Webseite und dem Server. So werden hinterlegte Daten wie Passwörter, Benutzernamen oder Angaben zur Person besser geschützt.

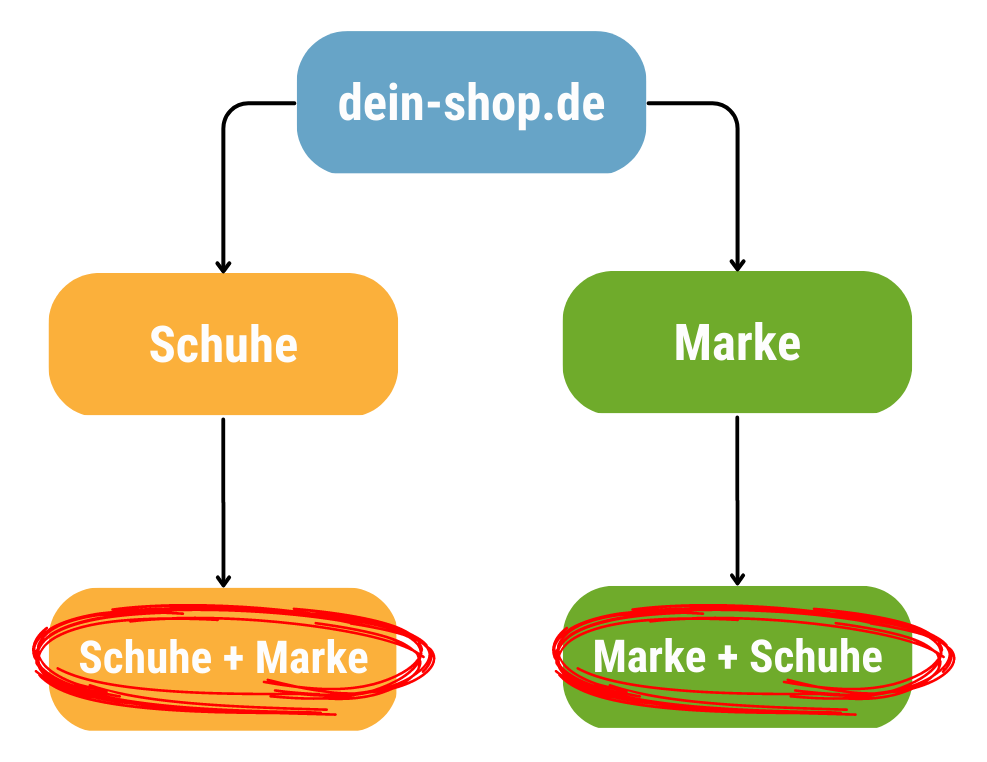

Ob die Webseite bereits ein SSL-Zertifikat besitzt, erkennst Du an dem zu Beginn der URL angezeigten Protokoll “https”. Ist kein SSL-Zertifikat vorhanden, wird Dir “http” angezeigt. Eine Verbindung ohne HTTPS wird von den meisten Browsern als unsicher gekennzeichnet.

Für Dein technisches SEO ist das in unterschiedlicher Hinsicht relevant. Einerseits ist eine sichere Verbindung mit HTTPS ein Rankingfaktor. Andererseits kann die Markierung als “unsichere Webseite” Deine Klickrate und das Nutzerverhalten negativ beeinflussen.

5. Verbessere die Mobilfreundlichkeit der Webseite

Seit Anfang 2021 gilt für Google der Ansatz “mobile first”. Die Suchmaschine betrachtet primär die mobile Version von Webseiten und lässt sowohl die Funktionalität als auch die fehlerfreie Darstellung auf Mobilgeräten als Faktoren in die Berechnung der Rankings einfließen. Für Technical SEO bedeutet das ganz konkret, dass Du Deinen Nutzern auf mobilen Endgeräten ein optimales Erlebnis bieten musst.

Um dies zu erreichen, empfiehlt Google die Verwendung eines Responsive Designs, das sich mithilfe von CSS automatisch an das Format des genutzten Endgeräts anpasst. So kannst Du auf die Erstellung separater URLs verzichten und reduzierst so auch das Risiko der Entstehung von URL-Duplikaten.

Alternativ kannst Du etwa auf verschiedene URLs für die unterschiedlichen Formate setzen. Das ist jedoch in der Regel aufwendig und erhöht das Risiko von Problemen durch doppelte Inhalte (Duplicate Content), die Deine Rankings gefährden können. Um dies zu vermeiden, kannst Du Deinen Seiten einen rel=“alternate“-Tag hinzufügen. In diesem Tag verweist dann die Desktopvariante einer Seite auf die mobile URL und umgekehrt.

6. Prüfe die Canonical Tags

Häufig entstehen mehrere Varianten einer URL, etwa durch Parameter, IDs, Filter, Varianten mit und ohne “www” oder durch Variationen in der Groß- und Kleinschreibung. Das stellt Google vor eine Herausforderung, denn die Suchmaschine muss beurteilen, welche der Varianten für die Indexierung bestimmt ist. Dies kann zu schlechteren Rankings führen, da die Duplikate zueinander in Konkurrenz treten.

Um Google mitzuteilen, bei welcher Seite es sich um die Hauptvariante – die kanonische URL – handelt, kannst Du den Canonical Tag <link rel=“canonical“ href=“deine-domain.de/hauptvariante-deiner-url/“> verwenden. Diesen bindest Du in der Kopfzeile jedes nicht zur Indexierung vorgesehenen Duplikats ein. Auch die kanonische Variante erhält einen Canonical Tag, der auf die kanonische Seite selbst verweist.

7. Lege eine XML-Sitemap an

Das Erstellen und Optimieren von XML-Sitemaps gehört zu den Grundlagen jeder technischen Suchmaschinenoptimierung. Dabei handelt es sich um eine Liste im Textdateiformat XML mit allen URLs, die die Suchmaschine indexieren soll. Sie kann etwa in der Google Search Console hochgeladen werden und wird vom Crawler genutzt, um neue Inhalte zu finden.

Für SEO irrelevante Seiten gehören daher nicht in die Sitemap. Denn stößt der Crawler immer wieder auf zu viele URLs, die er nicht indexieren darf oder die keinen relevanten Inhalt bieten, kann sich dies negativ auf das Crawlbudget der Webseite auswirken. Der Googlebot besucht die Website dann seltener oder crawlt eine geringere Datenmenge. Wichtige Inhalte werden dann mitunter erst spät oder gar nicht indexiert.

Anforderungen an die XML-Sitemap:

- Kodierung nach BUTF-8

- Komprimierung im Format .gz

- Referenzierung in der robots.txt

- Enthält nur kanonische URLs

- Enthält nur indexierbare und erreichbare URLs (Status Code 200)

- Listet maximal 50.000 URLs auf

- Hat eine maximale Größe von 50 MB

Überschreitet Deine XML-Sitemap die Größenbeschränkung oder das URL-Limit, kannst Du sie einfach auf verschiedene Sitemaps aufteilen. Hier empfiehlt sich eine Aufteilung nach Seitentypen, etwa Produktseiten.

8. Passe die 404-Seite an

Es kann vorkommen, dass ein Link oder eine eingegebene URL auf eine Seite ohne Inhalt führt, etwa wenn die URL falsch eingegeben wurde oder ein Seiteninhalt nicht mehr existiert. Dann sollten Nutzer nicht einfach nur eine leere Seite vorfinden, sondern mit einer optimierten 404-Seite davon abgehalten werden, die Seite zu verlassen.

Die 404-Seite sollte die Seitenbesucher darauf hinweisen, dass der Inhalt nicht oder nicht mehr verfügbar ist. Das Navigationsmenü sollte ebenfalls vorhanden sein, damit die Nutzer von hier aus durch Deine Webseite navigieren können. Idealerweise schlägt die 404-Seite auch gleich relevante Alternativen vor, also Seiten mit einem thematisch verwandten Inhalt.

9. Sorge für eine schnelle Ladezeit

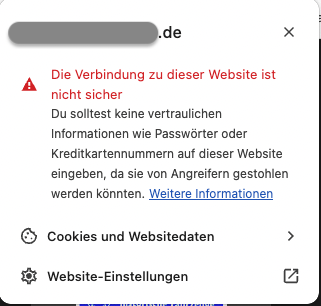

Die Ladegeschwindigkeit (Pagespeed) ist ein Rankingfaktor und besonders auf Mobilgeräten wichtig. Lädt die Seite langsam, steigt die Wahrscheinlichkeit, dass Nutzer vorzeitig abspringen, enorm. Eine Erhöhung der Ladezeit von einer Sekunde auf drei Sekunden bewirkt bereits einen Anstieg der Absprungwahrscheinlichkeit um 32 Prozent.

Durch technische SEO-Maßnahmen kannst Du den Pagespeed der Webseite verbessern. Dazu gehören unter anderem:

- leistungsstarken Server nutzen

- serverseitiges Caching aktivieren

- CSS und JS reduzieren

- ungenutzte CSS und JS-Ressourcen entfernen

- Lazy Loading verwenden

- Bilder komprimieren

- aneinandergereihte Weiterleitungen vermeiden

Du kannst die Ladegeschwindigkeit mit kostenlosen Tools wie PageSpeed Insights und der Google Search Console erfassen. Letztere bietet Dir eine Auswertung weiterer Performance-Metriken wie den Core Web Vitals. Sie messen:

- Wie lange die Seite benötigt, um das größte Element, ohne Scrollen, im sichtbaren Bereich zu laden (Largest Contentful Paint, LCP). Der Werte sollte unterhalb von 2,5 Sekunden liegen.

- Wie schnell die Webseite auf Interaktionen wie das Klicken auf einen Button reagiert (First Input Delay, FID). Dauert der Vorgang mehr als 100 Millisekunden, zeigt Google eine Fehlermeldung an.

- Ob es zu Layoutverschiebungen während des Ladevorgangs kommt (Cumulative Layout Shift, CLS). Derartige Verschiebungen können die Nutzererfahrung beeinträchtigen, daher sollte der Messwert maximal 0,1 betragen.

10. Seitentitel und Meta-Beschreibung

Ein optimierter Seitentitel und eine ansprechende Meta-Description können die Klickrate (CTR) in den SERPs positiv beeinflussen. Der Seitentitel (Title-Tag) ist zudem ein direkter Rankingfaktor. Daher gehört die Optimierung dieser Meta-Tags zu den Grundlagen im technischen SEO.

Gemeinsam bilden Title und Description das sogenannte Snippet – die Überschrift und die Beschreibung Deiner Seite in den Suchergebnissen. Sie sollten das Fokus-Keyword der jeweiligen Seite enthalten, den Seiteninhalt kurz beschreiben und zum Klicken anregen. Je nach Thema kannst Du dazu mitunter auch Sonderzeichen und Emojis (sparsam) einsetzen.

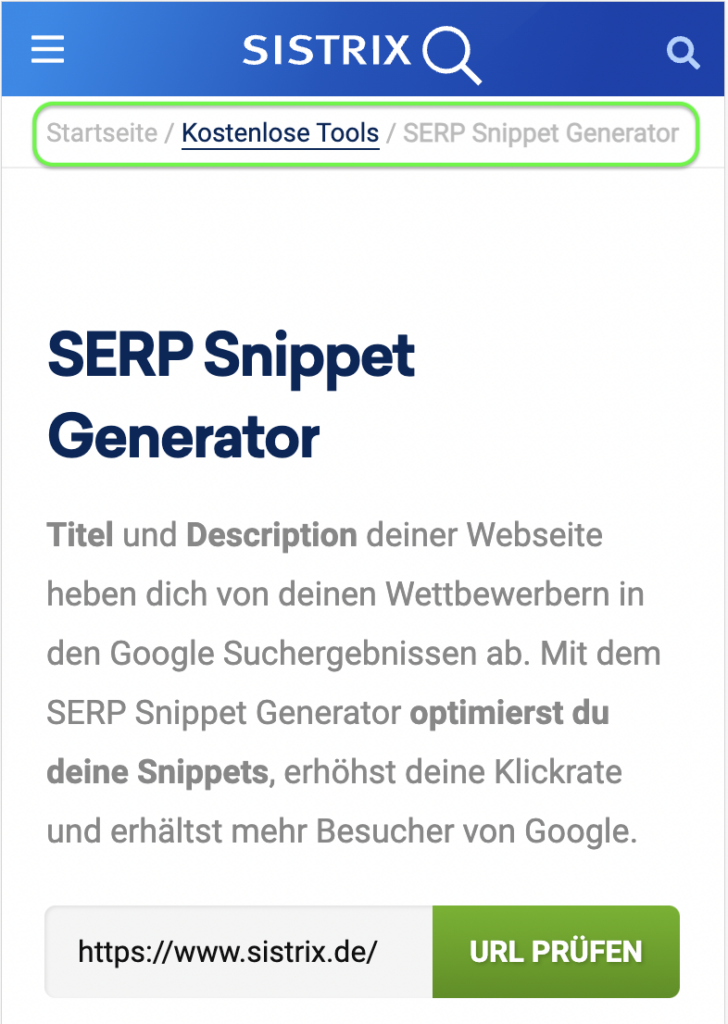

Dabei sind jedoch bei Weitem nicht alle Sonderzeichen zulässig, insbesondere im Title. Ein Blick auf die Snippets der Wettbewerber hilft dabei, herauszufinden, welche Zeichen Du verwenden kannst. Da Du nur wenig Platz zur Gestaltung der Meta-Tags hast, kannst Du den Sistrix SERP Snippet Generator nutzen, um Seitentitel und Description auf die richtige Länge zu bringen.

11. Verwende Breadcrumbs

Als Breadcrumbs werden kleine Navigationsmenüs bezeichnet, die sich oberhalb des Hauptinhalts befinden und eine schnelle Navigation zu übergeordneten Seiten ermöglichen. So ermöglichen sie Nutzern nicht nur, sich schneller durch Deine Webseite zu bewegen, sie schaffen auch mehr Übersichtlichkeit und zeigen auf, auf welcher Ebene der URL-Hierarchie man sich gerade befindet. Zusätzlich können auch Suchmaschinen-Crawler Breadcrumbs nutzen, um den Aufbau der Webseite besser zu verstehen.

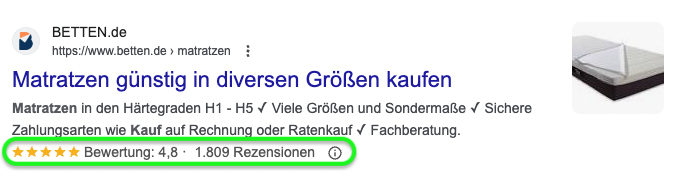

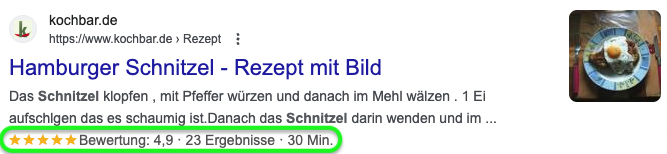

12. Pflege strukturierte Daten ein

Bei strukturierten Daten handelt es sich um ein standardisiertes Format, das es Suchmaschinen erleichtert, die Informationen einer Webseite zu verstehen. So können etwa Produktseiten mit strukturierten Daten speziell für diesen Seitentyp ausgestattet werden. So kann Google etwa Bewertungen, die Verfügbarkeit von Produkten und den Preis eindeutig klassifizieren und die Suchergebnisse mit Zusatzinformationen ausstatten, und das kann positiv auf die Klickrate auswirken.

Daher ist die Einbindung strukturierter Daten je nach Seitentyp eine wichtige Maßnahme in der technischen Suchmaschinenoptimierung, auch wenn es sich dabei nicht um einen direkten Rankingfaktor handelt.

Je nach Seitentyp, Inhalt und Branche stehen Dir unterschiedliche Schemata für strukturierte Daten zur Verfügung. So können regional tätige Unternehmen etwa das Schema “Local Business” nutzen und Daten wie Öffnungszeiten hinterlegen. Auf schema.org findest Du eine Vielzahl von Schemata und Vorlagen zur Einbindung in verschiedenen Formaten. Google empfiehlt das Format JSON-LD, das einfach als zusammenhängender HTML-Schnippsel in den Quelltext integriert werden kann.

13. Formatiere Deine Texte

Die Zeiten von Texten, in denen sich Keyword an Keyword reiht, sind schon lange vorüber. Um erfolgreich zu sein, müssen Deine Texte einen Mehrwert bieten und gut strukturiert sein. Diese Maßnahmen helfen Dir, verständliche und schnell lesbare Texte zu erstellen:

- Verwende hierarchisch gegliederte Zwischenüberschriften mit Heading-Tag (H-Tag)

- <h1>: Seitenüberschrift

- <h2>: Kapitelüberschriften, Zwischenüberschriften

- <h3>: Absatzüberschrift, der <h2> untergeordnete Überschriften

- Übersichtliche Textstruktur mit Einleitung, Zusammenfassung, Hauptteil und Fazit

- Kurze Sätze und Absätze

- Fettmarkierung einzelner wichtiger Wörter, die das Überfliegen erleichtern

- Verteile Keywords auf Überschriften und Fließtext

- Verlinke intern auf Seiten mit weiterführenden Informationen

- Gestalte Texte multimedial mit Bildern und Videos

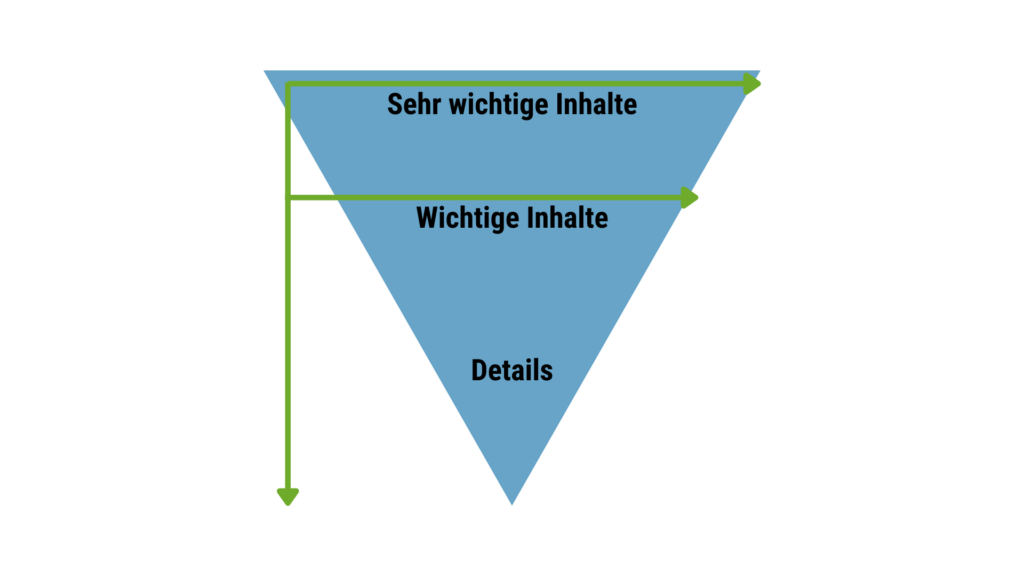

Bei der inhaltlichen Strukturierung Deiner Texte hilft das Prinzip der inversen Pyramide:

- Wichtige Informationen stehen zuerst, Detailwissen und weiterführende Inhalte folgen später

- Der erste Absatz steht für die gesamte Seite und enthält die wichtigsten Keywords

- Der erste Absatz des jeweiligen Kapitels steht für das gesamte Kapitel

- Der erste Satz eines Absatzes steht für den gesamten Absatz

Die so entstehende Textstruktur ist optimal an das Leseverhalten der Seitenbesucher angepasst. Nutzer suchen für gewöhnlich schnell nach Informationen und überfliegen den Text, indem sie dem F-Pattern oder Z-Pattern folgen. Dabei handelt es sich um typische Blickmuster, die der Form der Buchstaben F oder Z ähneln.

Die größte Aufmerksamkeit erhalten demnach die Inhalte, die sich am Seitenanfang befinden. Finden Nutzer hier nicht sofort den erwarteten Inhalt, verlassen sie die Seite meist umgehend. Daher solltest Du die wichtigsten Inhalte in diesem Seitenbereich positionieren, um die Nutzer auf Deiner Seite zu behalten.

14. Nutze Alt-Tags

Vereinzelt kann es vorkommen, dass Bilder nicht richtig geladen werden. Dann wird anstelle des Bildes der sogenannte Alt-Tag angezeigt. Dabei handelt es sich um einen kurzen Text, der den Bildinhalt beschreibt. Auch verbessert der Alt-Text die Barrierefreiheit der Webseite, denn er wird von Screenreadern für Menschen mit eingeschränkten Sehvermögen vorgelesen. Zusätzlich hilft Dir der Alt-Tag, die Rankings Deiner Bilder in der Google-Bildersuche zu verbessern.

So optimierst Du den Alt-Tag:

- Beschreibe kurz den Bildinhalt in 5 bis 6 Wörtern

- Verwende dabei das Fokus-Keyword der Seite

- Vermeide Keyword-Stuffing

Deine Checkliste für technisches SEO

- Kategorie- und URL-Struktur optimieren

- Duplicate Content prüfen und bereinigen

- Indexierbarkeit und Crawlbarkeit wichtiger Inhalte prüfen

- SSL-Zertifikat hinzufügen

- Mobilfreundlichkeit sicherstellen (Responsive Design)

- Canonical Tags prüfen und implementieren

- XML-Sitemap erstellen, in robots.txt und Search Console hinterlegen

- 404-Seite anpassen

- Ladegeschwindigkeit und Core Web Vitals verbessern

- Title-Tag und Meta-Description optimieren

- Breadcrumbs implementieren

- Strukturierte Daten einpflegen

- Texte gemäß inverser Pyramide und mit H-Tags formatieren

- Alt-Tags nutzen

Fazit: Technisches SEO schafft die Basis für gute Rankings

Der beste Inhalt nützt nichts, wenn Suchmaschinen ihn nicht finden, indexieren oder interpretieren können und Seitenbesucher aufgrund einer schlechten Nutzererfahrung vorzeitig abspringen. Technisches SEO setzt genau hier an und schafft die Voraussetzung dafür, dass die gängigen Offpage- und weiteren Onpage-Maßnahmen der Suchmaschinenoptimierung wirken können.

Technisches SEO ist ein fortlaufender Prozess und erfordert eine kontinuierliche Überwachung des technischen Zustands der Webseite. Für Seitenbetreiber und Unternehmen, die von organischen Klicks profitieren möchten, ist es daher wichtig, die benötigten Ressourcen bereitzustellen und die Kommunikation zwischen SEO und weiteren an der Umsetzung technischer Maßnahmen beteiligten Abteilungen zu fördern. Damit ist der erste Grundstein für mehr Umsatz durch gute Rankings bereits gelegt.

Christian optimiert seit 1998 Websites und berät Unternehmen seit 2005 im Online Marketing. Als Geschäftsführer der Agentur verantwortet er Marketing und Vertrieb. Gerne beantwortet er Fragen und sendet weitere Informationen zu.